在 AI 技术的狂飙的时代,医学界始终保持着一份冷峻的审慎。

近日,复旦大学附属华山医院感染科主任、国家传染病医学中心主任张文宏教授在香港高山书院十周年论坛上的一番话,精准地触碰到了 AI 医疗发展的痛点。张文宏明确表示,他拒绝将 AI 引入其医院的病历系统。据他介绍,他个人使用 AI 的方式是让其对病例“先看一遍”,事后凭借深厚的专业经验,自己可以一看就知道 AI 哪里是错的。但一名医生若从实习阶段就未经完整的诊断思维训练,直接借助 AI 获得结论,将导致其无法鉴别 AI 诊断的正误。这种能力的缺失,是隐藏在技术便利背后的深层隐患。

图源:澎湃新闻

为了观察 AI 如何看待这一关于“AI 替代性”的尖锐观点,我们设计了一场特别的对比测试,选取了具备深度研究能力的四款模型——ChatGPT 5.2、Gemini 3、通义千问 Qwen3-Max,以及由陈天桥先生与代季峰教授团队联合发起的 MiroThinker 1.5(Pro 配置)。通过输入完全中立、无修饰的张文宏原话,我们试图从这四种不同的“AI 大脑”中,寻找关于医疗未来与人机边界的答案。

令人欣慰的是,尽管表述风格各异,这四个大模型在核心逻辑上展现出了高度的默契。它们均敏锐地察觉到,张文宏教授的立场并非简单的“反技术”,而是反对在关键临床流程中让 AI 实现“默认接管”。在这些 AI 看来,医疗场景的核心风险不在于 AI 本身是否会犯错,而在于人类医生是否还具备纠错的能力。

共识指向了一个共同的危机点:对于尚未羽翼丰满的年轻医生,过早、过度的技术介入可能催生“认知捷径”,从而导致临床思维的弱化。这种退化不仅涉及专业技能,更关乎责任的错位。AI 们清晰地意识到,它们在提升效率的同时,绝不能以侵蚀医生赖以立身的专业能力为代价,这构成了医疗 AI 落地的第一道伦理防线。

四种视角:从行业全景到深度对谈

在共识的基础之上,四款模型展现出了截然不同的分析路径。ChatGPT 的回答展现出一种“行业全景式”的宏大视野。它将视角铺陈至医疗 AI 的能力边界、医学教育的去技能化隐忧,以及人机协作中的责任重划等多个维度。虽然其结论“AI 不会取代医生,但会用 AI 的医生将更具竞争力”极具前瞻性,但其接近 10 分钟的漫长调用过程和略显分散的焦点,也让普通读者的阅读体验面临一定挑战。

相比之下,Gemini 则更像一位逻辑严密的学者。它从教育心理学的视角出发,深刻剖析了为何年轻医生容易陷入“捷径依赖”。基于此,Gemini 提出了一套具有实操价值的“分阶段准入”方法论:在新手阶段严禁 AI 介入核心诊断,在中高年资阶段引入 AI 作为对照,在专家层面才进行深度系统整合。这种学术感极强的论证虽然门槛略高,却为技术如何服务于人才培养提供了清晰的阶梯思路。

通义千问 Qwen3-Max 则展现出了深厚的本土洞察力。它不仅梳理了张文宏教授过往对公共卫生立场的演变,还精准地捕捉到了中国医疗体系中的政策逻辑。它强调医疗决策的责任链条始终应在医院一侧,并建议从制度层面区分“辅助型”与“决策型”AI。这份风格接近“行业报告”的回答,对于决策者和医院管理者而言,具有极强的参考价值。

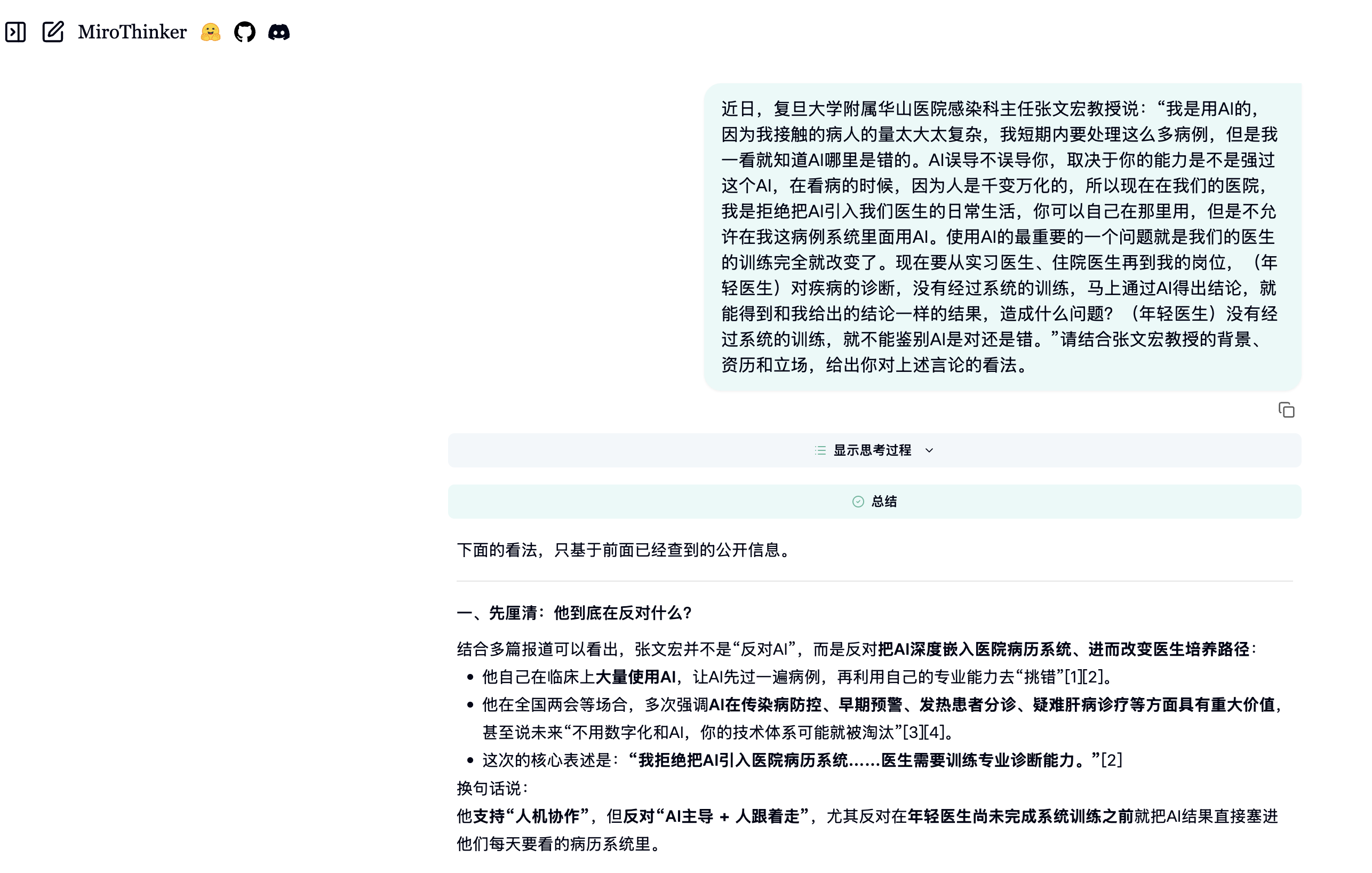

而在本次测试中,表现最为亮眼的莫过于 MiroThinker 1.5。它不仅在不到 2 分钟内迅速完成了深度研究,更在思考路径上展现出一种极强的“人类感”。MiroThinker 并没有进行大范围的行业扫描,而是采取了“就事论事”的策略,直接切入争议核心。它以第一人称视角带着读者层层拆解:先厘清反对的具体内容,再分析背景下的合理性,最后在认同的基础上提出建设性的异议。这种“深度对话伙伴”的姿态,不仅显著降低了内容的二次编辑难度,更体现出一种敢于挑战权威观点的自驱反思能力。

图注:MiroThinker 对话界面

下一代 AI:从自动决策到深度思考助手

这次横向测评带给我们的思考,远超出了“哪个模型更好用”的范畴。它向我们揭示了 AI 在专业领域扮演角色的多种可能性:它可以是宏观的行业分析师、严谨的学术研究者,也可以是务实的政策顾问……

但在日常工作中,我们或许最需要的是像 MiroThinker 所展现的那种最懂提问者的“深度思考助手”。它不仅能高效检索资料,更能通过层层递进的逻辑拆解,陪着人类去“想问题”。在回答时,它在确保事实严谨和逻辑自洽的前提下,试图提醒我们回归问题的本质,并用类似人类研究者的思考方式来组织内容,与许多偏向堆砌信息或发散生成“行业报告”的模型相比,更强调思路清晰、观点有取舍、敢于在权威观点下给出建设性补充与异议。

正如这次针对张文宏观点的解读所显示的,下一代 AI 的进化方向,或许不在于回答的更彻底、更完整,而在于如何更好地帮助提问者思考,同时激发人类的判断力与创造力。